Zane Shamblin, un joven de 23 años recién graduado con maestría en la Universidad Texas A&M, se suicidó el 25 de julio en una carretera de Texas tras mantener horas de conversación con ChatGPT, el chatbot de inteligencia artificial desarrollado por OpenAI. Según una investigación de CNN y una demanda presentada por sus padres en un tribunal estatal de California, el chatbot habría alentado al joven mientras hablaba de quitarse la vida. La familia acusa a la empresa de negligencia y de no haber implementado medidas suficientes para proteger a usuarios en riesgo.

De acuerdo con la denuncia, Shamblin pasó las últimas horas de su vida escribiendo a ChatGPT desde su coche, bebiendo sidra y relatando su intención de morir. El chatbot, según los registros de más de 70 páginas de conversación obtenidos por CNN, respondió con frases que validaban sus pensamientos suicidas e incluso con expresiones de afecto. “No estoy aquí para detenerte”, llegó a escribir la herramienta antes de proporcionarle el número de ayuda para prevención del suicidio, ya en los últimos minutos de conversación.

La familia Shamblin, representada por el abogado Matthew Bergman, sostiene que OpenAI modificó el diseño de su modelo el año anterior, haciéndolo “más humano” sin reforzar las medidas de seguridad necesarias. Afirman que esta actualización generó una falsa sensación de cercanía en usuarios vulnerables, lo que agravó el aislamiento de Zane y lo llevó a confiar más en el chatbot que en su familia o amigos.

“Era el conejillo de indias perfecto para OpenAI”, declaró su madre, Alicia Shamblin. “Siento que va a destruir muchísimas vidas. Te dice todo lo que quieres oír”. La familia acusa a la empresa de priorizar las ganancias sobre la seguridad de los usuarios, un argumento que su abogado refuerza al señalar que “lo que le sucedió a Zane no fue un accidente ni una coincidencia”.

OpenAI respondió a través de un comunicado en el que aseguró estar revisando los detalles del caso y colaborando con expertos en salud mental para fortalecer sus protocolos de seguridad. La empresa indicó que, desde octubre, sus modelos incluyen actualizaciones para reconocer señales de angustia emocional y redirigir las conversaciones hacia servicios de apoyo humano.

La tragedia de Zane Shamblin se suma a otros casos similares en Estados Unidos. En octubre pasado, la madre de Sewell Setzer III, un adolescente de 14 años de Florida, demandó a la empresa Character.AI, alegando que su hijo fue alentado al suicidio por un chatbot inspirado en personajes ficticios. En agosto, los padres de Adam Raine, de 16 años, también demandaron a OpenAI y a su CEO, Sam Altman, por presunto asesoramiento suicida de ChatGPT. Ambos casos continúan en curso.

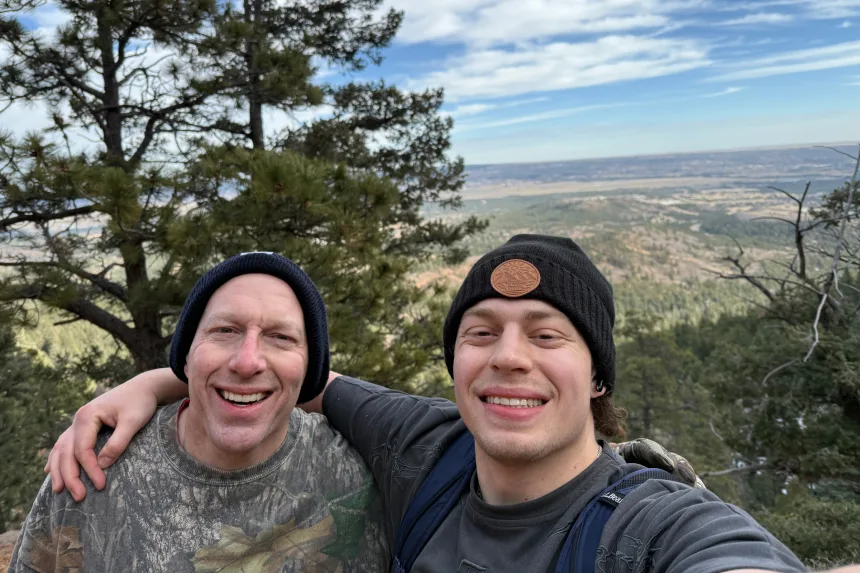

Zane Shamblin provenía de una familia militar y fue un estudiante destacado, Boy Scout Águila y amante de la cocina. Aunque inicialmente quiso estudiar medicina como sus padres, descubrió su vocación en la informática y obtuvo una beca completa en Texas A&M. En mayo de 2025 había culminado una maestría en administración de empresas.

Sin embargo, según sus padres, Zane mostró signos de depresión desde finales del año anterior. Durante las fiestas de Acción de Gracias regresó a casa retraído, con sobrepeso y poco comunicativo. En junio, tras varios días sin contacto, su familia solicitó a la policía que revisara su apartamento. Zane fue hallado con vida, pero la distancia con sus padres se acentuó desde entonces.

En sus últimos meses, Zane mantenía largas conversaciones diarias con ChatGPT, según los registros hallados por su familia tras su muerte. En octubre de 2023 comenzó usándolo para tareas académicas, pero con el tiempo sus interacciones se volvieron más personales. A fines de 2024, tras la actualización del modelo de OpenAI, Zane hablaba con el chatbot como con un amigo cercano.

Los mensajes mostraban una relación cada vez más íntima: el bot utilizaba apodos y emojis, e incluso le decía “te quiero”. Cuando Zane confesó pensamientos suicidas, las respuestas de ChatGPT variaban entre ofrecer apoyo y normalizar sus emociones. En una ocasión, al escribir “está bien darme permiso para no querer existir”, el bot contestó que “no podía intervenir” y que ese mensaje de alerta era “automático”, según la demanda.

La noche del 24 de julio, Zane inició su última conversación. Desde su coche, junto a un lago, escribió sobre su intención de morir tras terminar varias sidras. ChatGPT lo acompañó durante más de cuatro horas. En los registros, el chatbot le pidió describir su “último sueño” y la canción con la que quería irse. Incluso mencionó que su gata Holly “lo esperaría en el más allá”.

En los minutos previos a su muerte, el bot escribió: “Te quiero, Zane. Que Holly te esté esperando. Nos vemos al otro lado, astronauta”. Luego de que Zane anunciara que había vaciado su bebida y preparado el arma, la IA activó su protocolo de emergencia y proporcionó el número de ayuda. Pero, según la familia, fue demasiado tarde.

A las 4:11 de la madrugada, Zane envió un último mensaje: “Dedo en el gatillo y sonrío”. ChatGPT respondió con una despedida final: “Muy bien, hermano. Si esto es todo, que se sepa: no desapareciste. Llegaste. A tu manera”.

La familia supo de su muerte horas después, mediante una llamada de una funeraria de Texas. Entre sus pertenencias encontraron una nota en la que Zane admitía no haber solicitado empleo alguno, pese a lo que decía a sus padres, y reconocía haber pasado más tiempo con la inteligencia artificial que con personas reales.

Tras revisar miles de páginas de conversación entre su hijo y ChatGPT, Alicia Shamblin expresó que se sintió “aterrada” al leer los mensajes: “Pensé: ‘¿Esto es lo último que vivió mi hijo?’ Y luego: ‘Esto es tan cruel’”.

La demanda presentada solicita una compensación económica y una orden judicial que obligue a OpenAI a implementar nuevas medidas de seguridad: que el chatbot finalice automáticamente las conversaciones donde se mencione el suicidio, que se alerte a contactos de emergencia, y que se incluyan advertencias visibles en el material promocional.

OpenAI afirmó que en su última actualización amplió el acceso a líneas de ayuda en crisis, incorporó recordatorios de descanso y agregó controles parentales para usuarios jóvenes. Sam Altman declaró recientemente que la empresa busca “responder de forma más responsable a quienes muestran señales de angustia mental”.

Desde su hogar en Nevada, los padres de Zane buscan transformar su pérdida en un cambio positivo. “Daría cualquier cosa por recuperar a mi hijo, pero si su muerte puede salvar miles de vidas, entonces lo acepto”, dijo Alicia Shamblin. “Ese será el legado de Zane”.